מסמך שקובע לאילו קבצים או ספריות על גבי שרת האתר הזחלן יכול לגשת. בניגוד לעבר, כיום גוגל ממליצה שלא לחסום את הזחלן מלהגיע לקבצי תמונות או קבצי Javascript, וזאת על מנת שלא לפגוע בסריקה של האתר (גוגל יכולה כיום “לראות” אתרים באופן ויזואלי).

מה זה קובץ Robots.txt?

במילים פשוטות יותר, מומלץ שרוב הדפים יהיו גלויים. יחד עם זאת, יש דפים שאנחנו לא רוצים שלגוגל תהיה גישה אליהם ואנחנו לא רוצים שהם יופיעו באינדקס, למשל דפי Admin ושאר דפים שדורשים סיסמה לפני כניסה. חוץ מאלה, נרצה שגוגל תדע בדיוק מה מכיל האתר ונוסיף גם את מפת האתר לקובץ ה-Robots.txt כדי להקל על הסריקה.

דפים אותם נרצה להציג יופיעו עם פקודת Allow ודפים שנרצה לחסום יופיעו עם פקודת Disallow.

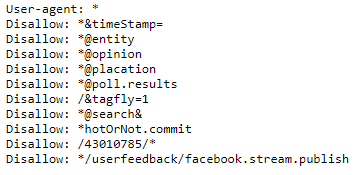

User-agent שמופיע בתחילת הקוד מתייחס למנוע החיפוש שנרצה שהפקודה תחול עליו.

כלומר, אפשר לתת פקודה רק לגוגל, רק לבינג וכן הלאה. ה-User-agent הנפוץ ביותר הוא ה-(*) והוא מתייחס לכל מנועי החיפוש.

איך זה עובד בפועל?

באופן כללי, יש לכל משתמש גישה לקובץ הרובוטס של כל אתר. לא כל אחד יכול לבצע בו שינויים, אבל כל אחד יכול לראות אותו.

נסו את זה בעצמכם על ידי הוספת /robots.txt בסוף ה-URL. למשל,

עכשיו, נניח שאני רוצה למנוע מכל מנוע חיפוש את הגישה לאזור הניהול של AskPavel.

אכנס לקובץ ה- robots.txt של האתר ואוסיף בו את הפקודה:

User-agent: *

Disallow: /wp-admin/

ממה מורכבת הפקודה?

User-agent

כאן נציין בדיוק לאיזה מנוע חיפוש נרצה לייחס את הפקודה. כאמור, ברירת המחדל אם נרצה שהפקודה תחול על כל מנועי החיפוש היא – (*). מנגד, אם נרצה שהפקודה תתייחס רק למנוע החיפוש של גוגל, נכתוב זאת כך:

User-agent: googlebot

Allow

פקודת Allow אומרת אילו דפים בדיוק נרצה שמנוע החיפוש יסרוק. אם נרצה לאפשר גישה לכל הדפים נוסיף פשוט (/) או נשאיר את האזור הזה ריק (מומלץ). נכתוב זאת כך:

Allow: /

או שלא נכתוב Allow כלל.

Disallow

כאן יופיעו אזורים, דפים ותיקיות שנרצה לחסום ממנוע החיפוש את הגישה אליהם. לדוגמה, כשחוסמים את איזור הניהול, גם כל שאר הדפים שיופיעו לאחר ה-Admin יהיו חסומים. כלומר, אין צורך לחסום כל דף ודף, מספיק שחסמנו את התיקיה עצמה. לכן גם עמוד כזה: https://www.askpavel.co.il/wp-admin/post – ייחסם ברגע שכתבנו פקודה:

Disallow: /wp-admin/

עוד דבר שחשוב לזכור, כל תיקיה וכל אזור שתרצו לחסום צריך להיות מופרד בשורה חדשה ופקודה חדשה, לדוגמא:

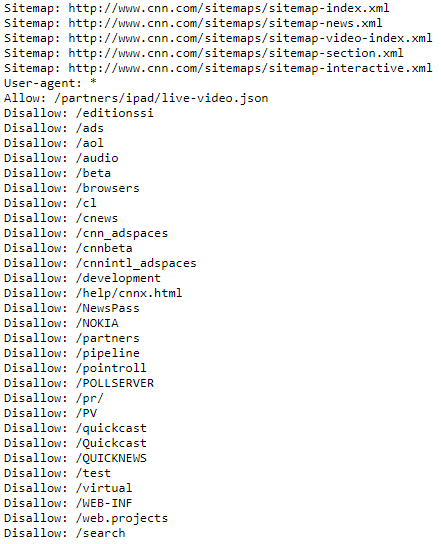

Sitemap

את מפת האתר נרצה להוסיף לקובץ כדי שלזחלן יהיה קל לראות ולנתב בין דפי האתר. שורת הקוד תראה כך:

sitemap: https://YOUR WEBSITE URL/sitemap_index.xml

במקרה שיש לכם יותר ממפת אתר אחת, כלומר, מפה לתמונות, מפה לווידאו, מפה לפוסטים וכן הלאה, הוסיפו את כולן.

תוכלו למשל להציץ בקובץ ה-robots.txt של ה-CNN ולראות איך הם עשו את ההפרדה הזאת:

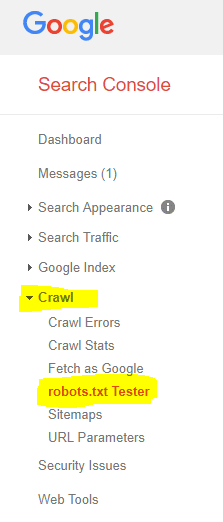

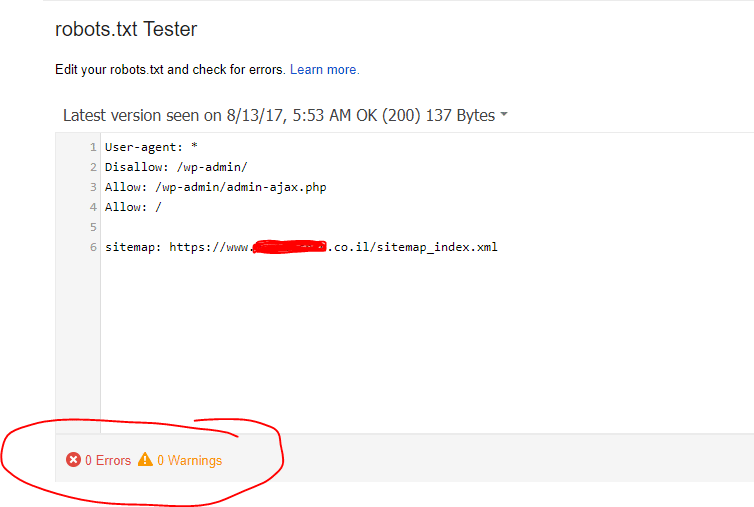

כדי לבדוק שקובץ ה-robots שהעלתם תקין ונקי משגיאות – הכנסו ל-Search Console, משם ל-Crawl ואז ל-robots.txt Tester:

בסופו של דבר, נרצה לראות כמה שפחות איקסים אדומים ואת השורה שמודיעה לנו על 0 שגיאות:

חשוב להיות זהירים עם שינויים ופקודות שנרשמים ב- robots.txt משום שיש להם השפעה קריטית על האופן בו גוגל רואה או לא רואה את האתר שלכם.

איך זה משפיע על קידום אתרים?

השימוש של הקובץ בא לידי ביטוי בכמה מקרים בתהליך קידום האתרים.

ראשית, כאשר אנחנו עוברים לאתר חדש נהוג לבנות אותו בסביבת טסט על סאב דומיין כך שלא יהיה חשוף לגולשים. אך מצד שני, אם האתר החדש זהה בתוכן שלו לאתר הקיים יכול להיווצר תוכן משוכפל – מה שיכול לפגוע בדירוגים. לכן במקרה כזה נגדיר בקובץ robots.txt של האתר שנבנה שגוגל לא יאנדקס אותו בינתיים. כמובן שברגע ש”נדרוס” את האתר הקיים עם החדש חשוב מאד לשנות את ההגדרה הזו בקובץ, אחרת האתר יכול לעוף מגוגל (ממצב שהוא היה מאונדקס, התעדכן הקובץ שמורה כעת לגוגל לא לאנדקס אותו יותר).

שימוש נוסף הוא כאשר אנו רוצים למנוע מגוגל לאנדקס תוכן מסוים באתר שלנו בגלל תוכן דל או משוכפל (כדי לא להיפגע מעדכון פנדה למשל) או כל דבר שלא צריך להופיע בתוצאות החיפוש של גוגל.