כמעט 40% מתנועת האינטרנט ב-2018 הגיעה מבוטים ושאר יישומים אוטומטיים, ולאו דווקא מבני אדם. אומנם בנתון הזה נכללים גם בוטים “טובים”, כגון גוגלבוט ושאר מנועי חיפוש – אבל בגדול חלק ניכר מהטראפיק העולמי שייך למכונות.

לפני כמה ימים הצצתי באנליטיקס של האתר שלי, וראיתי קפיצה אדירה בכניסות. ביום אחד בלבד היו פי 60 יותר כניסות בהשוואה לממוצע, עד כדי כך שגרף הכניסות הרגיל השתטח לחלוטין בהשוואה (וגרם לי לחשוב לרגע שאנליטיקס הפסיק לעבוד). במבט שני הבנתי במה מדובר – בוט, כמובן.

בהקשר הזה ראוי להבהיר שלא ניתן למנוע מבוטים לבקר באתר שלנו, אלא אם כן חסמנו מראש גישה עבור כתובות IP ו/או שרתים מוגדרים. אגב, מומלץ מאוד לא לחסום גישה לפי מדינות (בעיקר ארצות הברית) – מכיוון שאז אנו עלולים לחסום גם את הבוטים הטובים של מנועי החיפוש.

מעבר לבוטים שמייצרים כאבי ראש “קטנים” – כגון ספאם בטראפיק, במייל ובתגובות – יש בוטים שמטרותיהם “רעות יותר”: התקפת אתרים עד כדי קריסה (DOS, DDOS); בוטים שמחפשים פרצות אבטחה ועוד. במאמר זה נעסוק רק בבוטים שמייצרים טראפיק מזויף / המרות מזויפות.

איך מזהים בוטים

תהליך הזיהוי אינו קל, ובדרך כלל לא ניתן לזהות את רוב הבוטים שדופקים על דלת האתר. למרות זאת יש כמה אפשרויות בשרוול.

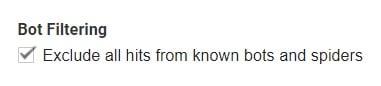

ראשית, כדאי לדעת שגוגל אנליטיקס עצמו כבר מכיל פיצ’ר ייעודי לנושא הזה. מדובר ברשימת בוטים מתעדכנת אוטומטית, שגוגל מזהה ויודע לפלטר החוצה מתוך הנתונים. זה לא מונע מהבוטים לזחול באתר, אבל זה כן מסנן החוצה את הכניסות שלהם מתוך הדוחות.

האופציה הזו לא מופעלת כברירת מחדל. כדי להפעיל אותה יש לגשת לאדמין ולאחר מכן ל-View Settings, ואז לוודא שיש סימן וי על האפשרות Bot Filtering.

עד כאן האפשרות האוטומטית, שלא תמיד מסננת את כל הבוטים (ראו דוגמה למקרה שתיארתי בהתחלה – הוא התרחש למרות שהפילטר הזה עובד). מעבר לכך די קשה לזהות בוטים “רעים”, מהסוג שאינו משויך למנועי חיפוש או לשירותים אחרים שאינם מזיקים (כגון כלים לבדיקת מתחרים).

החוכמה המקובלת אומרת שכל כניסה לאתר שנמשכת פחות משנייה אחת היא ככל הנראה בוט, אבל זה לא ודאי במאת האחוזים. שיטה אמינה יותר לזיהוי בוטים היא להסתכל בלוגים של השרת, אם כי זה דורש מעט יותר ידע טכני.

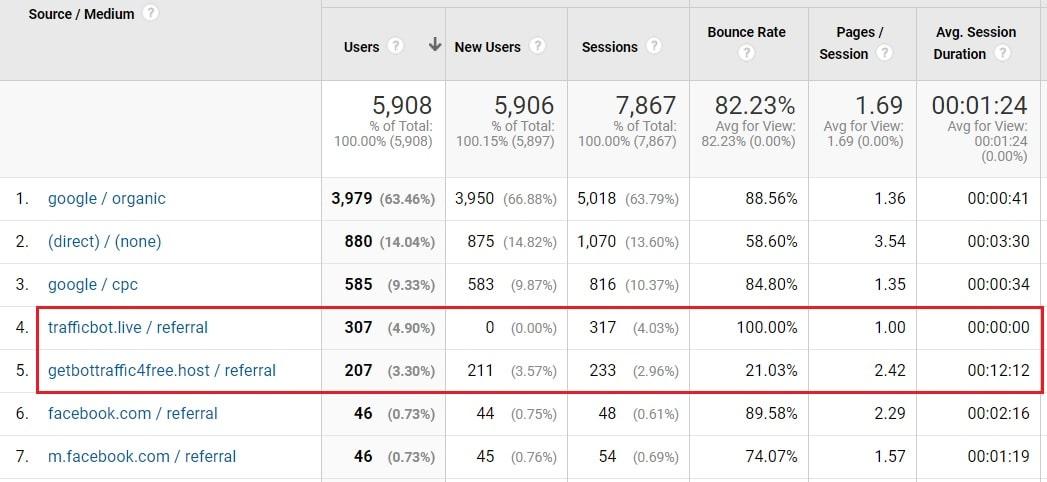

אפשרות נוספת ונגישה יותר היא לבדוק את דוח source / medium בגוגל אנליטיקס. בדוגמה שלפנינו ניתן לראות שני מקורות חשודים – בעיקר בגלל השמות שלהם המכילים את המילה bot. אחד מהם כולל גם נתוני שהייה לא הגיוניים, כגון אפס יוזרים חדשים, 100% באונס רייט ואפס שניות זמן שהייה.

לכאורה זה סימן מיידי לבוט, אבל אם נביט במקור השני מתחתיו – נראה שהוא מצליח לעשות חיקוי מוצלח של משתמשים אנושיים (כולל זמן שהייה של מעל 12 דקות). בכל מקרה, עצם העובדה שמדובר במקורות תנועה חריגים, מספיקה כדי להדליק אצלנו נורה אדומה.

שוב נזכיר שדי קשה לזהות בוטים, כי חלקם כבר מספיק חכם כדי לחקות התנהגות אנושית (כפי שראינו בצילום המסך) – כולל זמן שהייה, מילוי טפסים וגם מילוי קאפצ’ות. גוגלבוט אפילו מסוגל למלא סל קניות באתרי מכירות ולהגיע לעמוד הצ’קאאוט, כדי לוודא את תקינות התהליך המכירתי באתר (ולא כדי לגרום נזק, כמובן).

אחת השיטות היעילות למניעת ספאם אוטומטי בטופסי צור קשר, היא להשתמש בתוסף וורדפרס שנקרא “מלכודת הדבש” (Honey Pot). התוסף מייצר בטופס שדה מזויף, שרק בוטים אוטומטיים הפועלים בעיוורון ינסו למלא. אומנם התוסף מונע מהבוט מילוי ושליחה של הטופס, אבל כמובן שאינו מונע ממנו לזחול באתר.

גם תחום הפרסום הממומן, בעיקר בגוגל, סובל מהטרדות בלתי פוסקות של בוטים. מדובר בדרך כלל בבוטים שמייצרים קליקים מזויפים על מודעות, במטרה לבזבז את תקציב הקמפיין ולעצור אותו; או במטרה להוריד את ציון האיכות על ידי הצפה בקליקים שאינם מובילים בסוף להמרה.

בתחום ה-PPC יש מספר פתרונות – ראש וראשון להם הוא חברת גוגל בעצמה, שמכירה בבעיה ואף מציגה את הקליקים המזויפים בעמודה נפרדת בדוחות גוגל אדס. יש לציין שגוגל אינה מחייבת את המפרסם עבור קליקים מזויפים, ומאפשרת גם לחסום כתובות IP כדי לצמצם את התופעה. למרות זאת גם גוגל הכל יכולה אינה מסוגלת לאתר את כל הבוטים, מה שמשאיר ואקום לספקי שירות חיצוניים, כגון ClickCease אם נמנה את הידועים בהם.

איך חוסמים בוטים

מכיוון שהבוטים הופכים להיות חכמים יותר עם השנים, גודל המטרד שהם מייצרים גדל בהתאם. בכל הנוגע לתחום הדיגיטל, זה מתבטא בעיקר בטראפיק מזויף ולעיתים אף בהמרות מזויפות.

אם אין לכם אפשרות לחסום תנועת בוטים ברמת השרת, ניתן להשתמש בשירותי CDN המציעים רמת אבטחה מוגברת כגון קלאוד פלייר ואחרים. כמו כן יש גם תוספי וורדפרס שמיועדים לעשות את העבודה הזו; חפשו אותם במאגר התוספים עם מילות מפתח כגון bots, spam ועוד.

מעבר לכך תוכלו לסנן החוצה את הכניסות המזויפות באמצעות פילטור מתאים בגוגל אנליטיקס. חשוב לציין שהפילטרים באנליטיקס עובדים רק מרגע הקמתם ולא בצורה רטרואקטיבית.

חסימת בוטים בגוגל אנליטיקס

מעבר לאופציה האוטומטית שהוצגה בתחילת המאמר, ככל הנראה תיאלצו לבצע גם חסימות ידניות מדי פעם (בהתאם לבוטים שיתגלו בדוחות התנועה לאתר). כאן נציג שתי שיטות עיקריות לחסימת בוטים – האחת משתמשת בשם המארח (hostname) והשנייה מסננת בוטים ספציפיים.

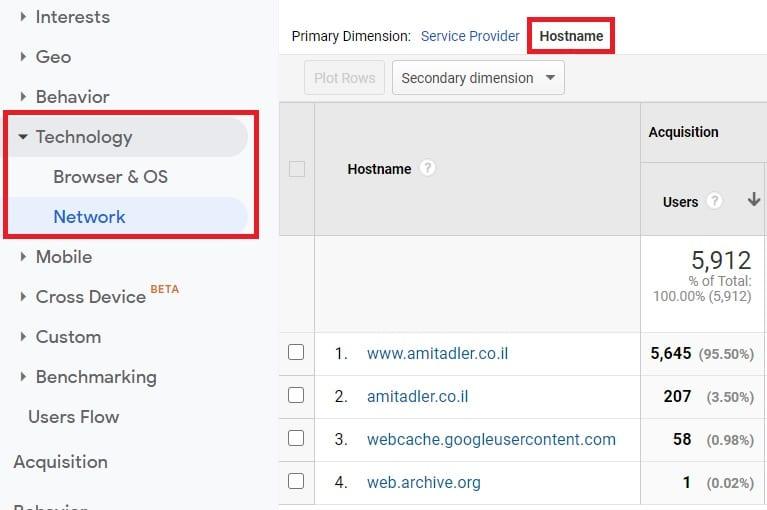

חסימת בוטים באמצעות Hostname

כאן מדובר בבוטים שלא באמת מבקרים באתר שלכם, אלא “עובדים” על גוגל אנליטיקס ומשתמשים בו כדי ליצור טראפיק מזויף. כדי לסנן אותם ראשית ניגש לדוח הבא: Audience > Technology > Network

בראש הדוח נקליק על Hostname ואז נקבל רשימה של שמות מתחם. חלק מהם יהיו תקינים (כגון שם המתחם של האתר שלנו: website.co.il) וחלק ייראו חשודים ולא רלוונטיים.

מומלץ לבדוק קודם כל בגוגל מה משמעותו של כל שם מתחם חשוד, כדי שלא נחסום בטעות משהו חשוב. למשל, אם אתם רואים שם מתחם שכולל את שם האתר שלכם + googleweblight.com (או שירותים דומים של גוגל), רוב הסיכויים שמדובר בשם מתחם תקין ורלוונטי שלא כדאי לכם לחסום.

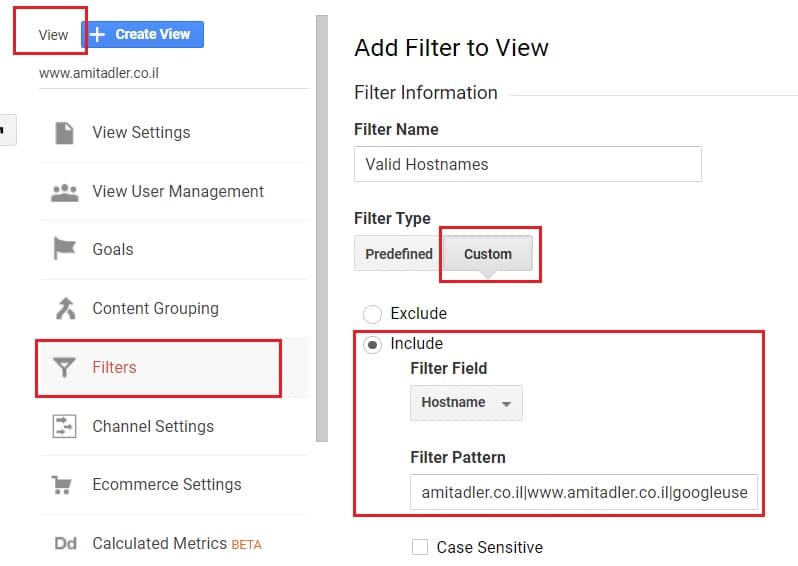

את כל שמות המתחם התקינים נציב במסנן חדש שנקים באנליטיקס מסוג Custom, שיכלול את ה-hostnames שאנו רוצים (ביניהם מפריד קו אנכי). צריך להציב את כל ההוסט ניים התקינים בפילטר אחד, כי אי אפשר להקים עוד אחד מאותו סוג. כך בעצם אנו מורים לגוגל לכלול רק תנועה שמגיעה משם מתחם תקין הקיים בפילטר.

חסימת בוטים ספציפיים

בשיטה השנייה לא ניתן להשתמש בהוסט ניים, מכיוון שהבוטים הללו באמת מבקרים באתר שלכם (בניגוד לבוטים בשיטה הקודמת, שמשתמשים ב-hostname מזויף). כדי לזהות את הבוטים הללו ניגש לדוח הבא: Acquisition > All Traffic > Source/Medium

ברשימה נחפש את מקורות התנועה שנראים חשודים, או כאלה שאנו כבר יודעים מראש שמגיעים מבוטים. במקרה הזה, מדובר בשני מקורות התנועה שהצגתי קודם לכן. אפשר למצוא את הנתונים גם בדוח ה-referrals בתפריט הראשי.

אם אינכם בטוחים לגבי מקור מסוים, חפשו אותו בגוגל (אבל אל תקליקו עליו – זה בדיוק מה שהספאמר רוצה שתעשו).

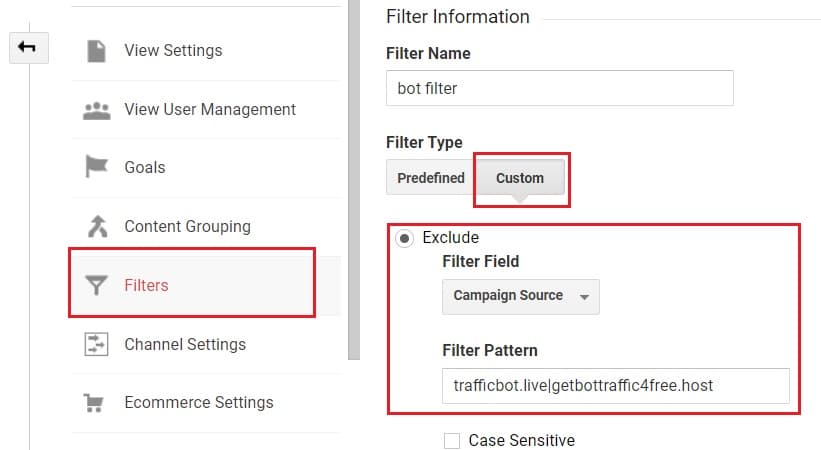

כמו בשיטה הקודמת נקים פילטר custom חדש, אבל הפעם בפורמט exclude – ובמקום hostname נבחר campaign source:

רגע לפני סיום

כפי שצוין כבר בתחילת המאמר, אין פתרון אחד מקיף שיכול למנוע כניסה של בוטים לאתרים. גם הפילטרים הידניים שהוצגו כאן מצריכים מעקב מדי פעם בפעם, ולעיתים הוספה של מקורות נוספים לרשימה.

עוד אפשרות שלא הוצגה כאן בהרחבה היא חסימת בוטים של כלים שונים, כגון Ahrefs, מג’סטיק, Semrush ואחרים. שירותים אלו סורקים אתרים כדי לעקוב אחר מניין הקישורים הנכנסים ושאר פרמטרים. למרות שלא מדובר בבוטים בעייתיים, לא כולם רוצים שתהיה אפשרות לעקוב אחר האתרים שלהם.

ניתן לחסום את הבוטים הללו בשתי דרכים עיקריות – תגית מטה רובוטס (היעילה ביותר) וכן קובץ רובוטס.

כך זה נראה באמצעות התגית:

<meta name=”AhrefsBot” content=”noindex” />

<meta name=”MJ12bot” content=”noindex” />

<meta name=”SemrushBot” content=”noindex” />

כך זה נראה בקובץ רובוטס:

User-agent: SemrushBot

Disallow: /

User-agent: MJ12bot

Disallow: /

User-agent: AhrefsBot

Disallow: /

אם אתם מכירים פתרונות נוספים לזיהוי ולחסימה של תנועת בוטים, נשמח אם תשתפו אותנו בתגובות.

בהצלחה!